Auch in der virtuellen Realität möchte man Texte eingeben. Welche Methoden dafür in Frage kommen und welche für die Nutzer am komfortabelsten sind, haben Forscher der DFKI untersucht.

In den letzten Jahren sind Virtual Reality (VR) und 3D-Benutzerschnittstellen (3D UI) immer populärer geworden. Während die Technologie für Ausgabe- und Eingabegeräte marktreif geworden ist (siehe Oculus oder HTC Vive ), existieren nur wenige effiziente und gleichermaßen bedienerfreundliche Lösungen für die Texteingabe in virtuellen Umgebungen.

In einer empirischen Vergleichsstudie [Speicher et al, 2018] haben wir die selektive Texteingabe mit aktuell gängigen Interaktions-Techniken in VR untersucht, d.h. wie man Zeichen auf einer virtuellen Tastatur mit verschiedenen Eingabemethoden auswählen kann.

Wir beschreiben außerdem den „Design Space“ (Gestaltungsraum) für die Evaluation selektiver Texteingabe in VR. Dazu haben wir sechs vergleichbare Methoden implementiert und haben deren Leistung und Nutzerpräferenzen in einer Studie verglichen.

Die Ergebnisse der Studie zeigen deutlich, dass das „Controller Pointing“ – also das Zeigen mit einem getrackten Handheld-Controller auf die Tasten der virtuellen Tastatur – alle anderen getesteten Methoden in allen Aspekten übertrifft.

Andere Methoden wie „Head Pointing“ oder „Continuous Cursor“ können je nach verfügbaren Ressourcen praktikable Alternativen sein, beispielsweise wenn keine getrackten Controller zur Verfügung stehen oder die Hände frei sein müssen.

Da textbasierte Kommunikation in der VR-Forschung meist hinsichtlich der Effizienz der Texteingabe untersucht wird [ Markussen et al, 2013 ] [ McGill et al, 2015 ] [ Walker et al, 2017 ] [ Gonzalez et al, 2009 ], ist es notwendig, auch die Präferenzen der Nutzer (beispielsweise User Experience, kognitive Belastung, Motion Sickness) und typische Merkmale von VR wie Interaktivität und Immersion hinsichtlich aktueller Technologien und Interaktions-Konzepte für die Texteingabe in VR mit in die Untersuchung einzubeziehen und zu bewerten.

Darüber hinaus werden häufig Gestaltungsrichtlinien für die Texteingabe ohne weitere Untersuchungen direkt aus Nicht-VR-Systemen übernommen.

Aber was passiert, wenn getrackte Controller nicht verfügbar sind oder wenn geringe physische Belastung und Motion Sickness von höherer Bedeutung sind als reine Effizienz oder User Experience?

Zudem stellt sich die Frage, ob die natürliche (oder isomorphe) Interaktion mit Finger oder Stift zur Eingabe einen Einfluss aufgrund der Vertrautheit aus der Realität auf die Leistung und Bedienerfreundlichkeit der Texteingabe hat.

In diesem Zusammenhang charakterisiert der „Isomorphismus“ (also die Natürlichkeit der Interaktion) die Abbildungen zwischen Bewegungen in der realen Welt und ihrer Wirkung in der virtuellen Umgebung [ Bowman et al, 2004 ]. Eine isomorphe Technik verwendet 1:1-Mappings zwischen virtueller und realer Welt, gilt als der natürlichste Ansatz der Interaktion und könnte durch die hohe Vertrautheit beim Nutzer gute Ergebnisse erzielen.

Die traditionelle Texteingabe (Finger drücken die Tasten auf einer virtuellen oder auch physikalischen Tastatur) könnte sich möglicherweise bei Nicht-Desktop-3D-Benutzerschnittstellen nicht durchsetzen, da VR-Nutzer im Allgemeinen nicht fixiert auf einem Stuhl vor einem Tisch sitzen, sondern eher innerhalb der getrackten Fläche mobil sind.

Um Einschränkungen im Tracking-Raum oder anatomische Einschränkungen zu überwinden, ermöglichen nicht-isomorphe („magische“) Techniken dem Nutzer die Interaktion mit „übernatürlichen“ Metaphern, beispielsweise das Teleportieren im Raum oder das Zeigen mit einem Strahl auf die Tastatur im Hinblick auf die Texteingabe in VR.

Das Tippen auf einer virtuellen Tastatur mit Live-Feedback (visuell oder akustisch) hat entscheidenden Einfluss auf Tippleistung und Präferenzen der Nutzer beim Tragen einer VR-Brille [ Lin et al, 2017 ]. Besonders für schnelle und fehlerfreie Eingaben wären physikalische Tastaturen für textlastige Interaktionen nützlicher, jedoch nicht für den mobilen Einsatz oder im Stehen, wie es normalerweise bei herkömmlichen VR-Setups (beispielsweise room-scale HTC Vive) der Fall ist. Hier könnten Verfahren mit VR-Controllern (etwa Zeigen oder Cursor) oder gar ohne Controller (wie Head Pointing [ Yu et al, 2017 ] oder Spracheingabe [ Bowman et al, 2002 ]) besser geeignet sein.

Abgesehen von der Spracherkennung und dem Head Tracking konnte sich bisher keine Methode der Effizienz einer physikalischen Tastatur annähern, wohingegen einige Methoden im Hinblick auf die Präferenzen des Nutzers anstelle der reinen Leistung nützlicher erscheinen.

Wir haben daher untersucht, wie die Texteingabe über eine virtuelle Tastatur in VR sowohl in bezug auf übliche Evaluationsmetriken, Leistung als auch Nutzerpräferenz unterstützt werden kann.

Selektive Texteingabe

Derzeit gibt es keine Standard-Methode für die VR-Texterfassung und aktuelle kommerzielle Systeme implementieren meist ihre eigenen Techniken. Fast ausschließlich basieren diese auf einem Auswahlparadigma, bei dem die Zeichen sequenziell auf einer virtuellen Tastatur vom Nutzer ausgewählt werden. Dieses Paradigma ist Nutzern aus anderen Systemen bekannt, geeignet für den mobilen Einsatz (d.h. im Stehen oder Gehen) und damit leicht an VR anzupassen.

Da es bisher keine Taxonomie von Texteingabe-Methoden mit virtuellen Tastaturen in VR gibt, auf die wir uns beziehen können, haben wir den Begriff „selektive Texteingabe“ gewählt, wie er in verwandten Arbeiten verwendet wird [ Markussen et al, 2013 ]. Dennoch können Leistung und Präferenz bei solchen Systemen je nach der zur Auswahl stehenden Eingabe-Methode stark variieren.

Design Space für selektive Texteingabe in der Virtuellen Realität

Um die Frage zu beantworten, welche Methode für bestimmte Szenarien gewählt werden sollte, präsentierten wir in unserer Studie einen Design Space für die selektive Texteingabe in VR, basierend auf [ MacLean et al., 1991 ]. Dieser Design Space besteht aus drei Schlüsselkomponenten:

-

Fragen (darüber, was ein Design leisten soll)

-

Optionen (Antworten auf die Fragen) und

-

Kriterien (Möglichkeiten zur Beurteilung von Designs)

Fragen und Optionen

Es gibt nur wenige Untersuchungen zum Vergleich von Texteingabe-Methoden in VR, so dass wir davon ausgehen, dass noch einige Fragen offen sind. Vor allem für Designer von VR-Anwendungen gibt es zu wenig Orientierung, da es keinen gemeinsamen Zusammenhang zwischen VR und Texteingabe gibt:

-

Frage 1: Welches Tastaturlayout?

-

Frage 2: 2D oder 3D?

-

Frage 3: Tippen auf der Tastatur in bezug worauf?

-

Frage 4: Position und Größe der Tastatur?

-

Frage 5: Feedback geben, ja oder nein?

Ausführliche Beschreibungen und Details zu den Fragen und Optionen sind in unserer Studie zu finden.

Kriterien

Die Texteingabe in VR-basierten Anwendungen erfordert die Validierung und Evaluation von Befunden und Antworten aus der Forschung auf neue und aktuelle Fragen und sollte sich daher auf bestimmte Kriterien stützen. Vor allem neuartige VR-Anwendungen und ihre Interaktions-Techniken zur Texteingabe basieren meist auf Richtlinien und Standards aus Nicht-VR-Bereichen.

Hierzu kombinieren wir die Standard-Metriken, um die Leistung von Texteingabe-Methoden zu erfassen („Text Entry Performance“) als Teil der allgemeinen Evaluationsmetriken für 3D-Benutzerschnittstellen [ Bowman et al, 2004 ] und Merkmale von Virtual Reality.

Texteingabe Performance

Diese Kennzahlen zeigen an, inwieweit die Nutzer in der Lage sind, mit der Aufgabe und der Interaktions-Methode umzugehen. Die Auswertungen der Texteingabe konzentrieren sich in der Regel auf die gleiche objektive Statistik, Geschwindigkeit und Genauigkeit. Dennoch sind wiederholte Versuche notwendig, um große Datenmengen zu erzeugen, bestehend aus präsentiertem Text (dem Stimulus, d.h. dem, was sie eingeben sollten) und transkribiertem Text (was sie tatsächlich eingegeben haben).

Bei der Durchführung von Texteingabe-Experimenten, bei denen die Teilnehmer mehrere Sätze hintereinander eingeben müssen, sollten die Wörter pro Minute (WPM) zur Geschwindigkeitsmessung gewählt werden, was auch der aktuelle Standard für die Bewertung der Texteingabe ist.

Wir empfehlen weiterhin, die Genauigkeit anhand der Fehlerquote zu bestimmen, also das Verhältnis des korrekt eingegebenen Textes zum gesamt eingegebenen Text bzw. der minimalen Distanz zwischen präsentiertem und transkribiertem Text.

Nutzerpräferenzen

Die Präferenz des Nutzers besteht in der Regel aus subjektivem Feedback wie User Experience, kognitiver Belastung und Motion Sickness [ Bowman et al, 2004 ].

User Experience umfasst klassische Usability-Faktoren (Effizienz, Verständlichkeit, Zuverlässigkeit) und spezielle Aspekte der User Experience (Attraktivität, Neuartigkeit, Stimulation) [ Laugwitz et al, 2008 ].

Kognitive Belastungsmerkmale umfassen mentale, physische und zeitliche Belastung sowie subjektive Leistungs-, Anstrengungs- und Frustrationswerte [ Hart, 1988 ].

Die Werte für Motion Sickness schließlich spiegeln wider, wie schwindelig oder unwohl sich der Nutzer fühlt [ Gianaros et al, 2001 ].

Merkmale der Virtuellen Realität

Darüber hinaus wollen wir auch Merkmale von VR einbeziehen wie Immersion, Interaktivität und Präsenz [ Lee & Chung, 2008 ]. Immersion und Präsenz können zu einem Merkmal kombiniert werden, d.h. inwieweit die Sinne des Nutzers vom Realen isoliert und durch die virtuelle Welt stimuliert werden, und durch die subjektive Erfahrung, in einer Umgebung zu sein, aber physisch in einer anderen. Die Interaktivität gibt an, inwieweit Nutzer an der Manipulation virtueller Inhalte in Echtzeit teilnehmen können.

Unter den Kategorien des Design Space und auf der Grundlage der damit verbundenen Arbeiten haben wir sechs Kandidaten für die Texteingabe ausgewählt und implementiert. Wir verwendeten sowohl das Zeigen durch die Position und Orientierung des Kopfes (Head Pointing) und der getrackten Controller (Controller Pointing), die als aktuelle Standards für die VR-Texterfassung gelten, die kontinuierliche (Continuous Cursor) und diskrete Cursor-Steuerung (Discrete Cursor) von aktuellen 3D-Spielkonsolen sowie die Controller-Tapping- und Freehand-Methoden als natürliche und direkte Ansätze, da sie der Standard für nicht-virtuelle Tastatur-Interaktionen sind.

Head Pointing

Das Pointing ist eines der grundlegendsten Muster für die Selektion [ Jerald, 2015 ] und wird normalerweise mit dem Kopf oder der Hand bzw. dem Controller durchgeführt. Die Grundidee des Head Pointing ist, mit einem imaginären Strahl aus der Sicht des Nutzers auf das Zielobjekt durch die virtuelle Umgebung zu zeigen. Die Selektion wird dann durch einen nutzergesteuerten Auslöser (etwa Button am Controller oder „dwelling time“) bestätigt.

Controller Pointing

Die Implementierung der Controller-Pointing-Methode ist analog zum Head Pointing, ermöglicht aber ein „bimanuelles“ Zeigen mit beiden Reglern, im Vergleich zum Head Pointing mit nur einem möglichen Cursor. Darüber hinaus ist es für Szenarien konzipiert, in denen ein Controller-Tracking verfügbar ist und erweitert einen Strahl von jedem Controller (siehe Nintendo Wii über optisches Tracking via Infrarot). Hier steuert der Nutzer die Positionen der Cursor auf einer virtuellen Tastatur, indem er einfach auf das Zeichen zeigt, um es auszuwählen. Die Zeichenauswahl erfolgt dann durch Drücken einer Auslösetaste.

Controller Tapping

Die Controller-Tapping-Methode basiert auf der Pen & Tablet-Metapher und bietet eine natürlichere, direkte und realistische Interaktion. In unserem Ansatz werden die HTC-Vive-Controller verwendet, um mit den virtuellen Tasten zu interagieren, indem sie umgekehrt und wie digitale Stifte gehalten werden (siehe Abbildung). Im Gegensatz zum Pointing erfordert dieses Verfahren eine physikalische Manipulation, d.h. die virtuellen Tasten müssen mit den getrackten Handheld-Controllern „in der Luft“ gedrückt werden.

Freehand

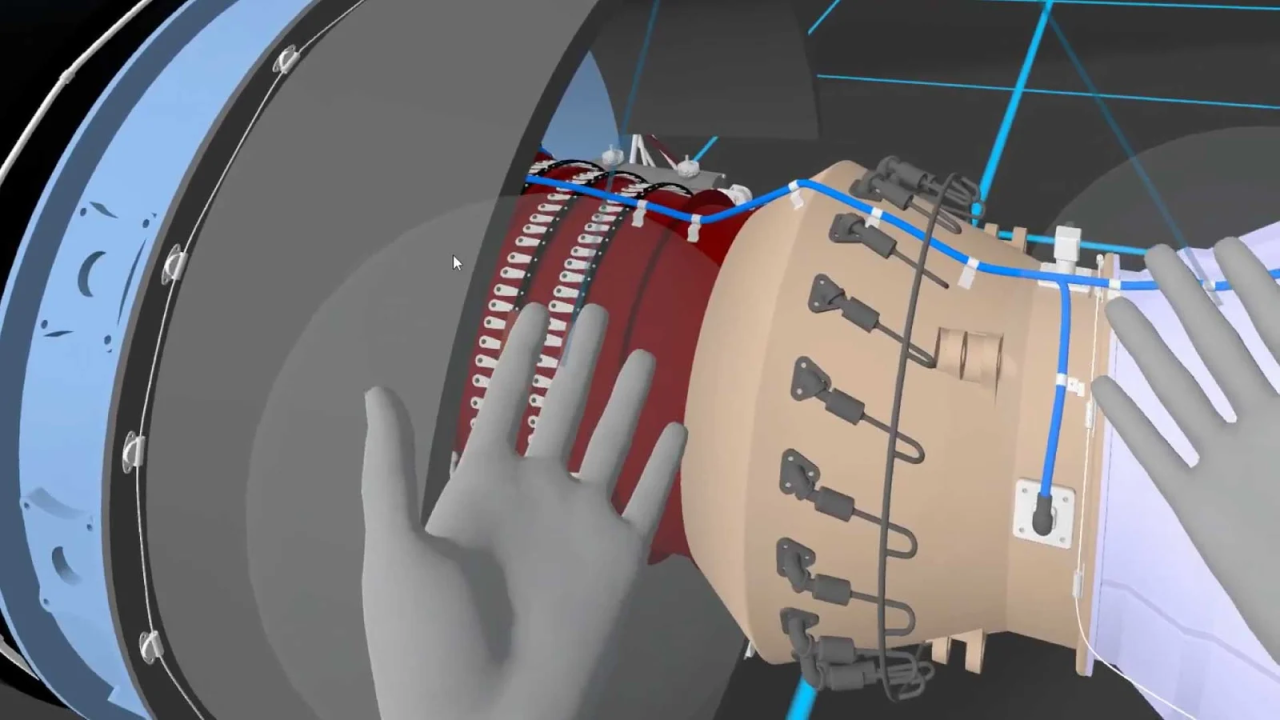

Unser natürlichster und realistischster Kandidat für die Texteingabe ist die sogenannte Freehand-Technik, bei der die Finger des Nutzers getrackt werden, um direkt auf der virtuellen Tastatur zu tippen. Bei dieser Technik sind keine Handheld-Controller erforderlich, lediglich das Tracken der Finger mittels Handschuh oder rein optisch durch die Leap Motion. Die Leap Motion bietet allerdings aufgrund ihrer technischen Einschränkungen kein präzises Tracking und kann sich daher negativ auf die Leistung und Präferenz auswirken. Wir haben uns trotzdem für die Leap Motion entschieden, da sie die derzeit günstigste und verfügbarste Methode zum Finger-Tracking und zur Visualisierung für VR-Anwendungen ist.

Pad-based Discrete Cursor Control

Die Mehrheit der Spielkonsolen verwendet Texteingabe-Methoden über den angeschlossenen Controller, genauer gesagt mit dem Steuerungskreuz (dem „d-Pad“) oder den Thumb-Sticks. In den meisten Fällen wird die Texteingabe durchgeführt, indem ein diskreter Cursor über eine Qwertz-Tastatur zur Zeichenauswahl gesteuert wird und die Eingabe über eine weitere Auslösetaste bestätigt. Diese Methode haben wir in unserer Studie auf die HTC-Vive-Controller übertragen, die ebenfalls mit einem d-Pad ausgestattet sind und mit dem Daumen des Nutzers bedient werden.

Pad-based Continuous Cursor Control

Die zweite d-Pad-Methode in unserer Auswahl ist die sogenannte Continuous-Cursor-Methode, die die Funktionalität des Discrete Cursors erweitert. Der Unterschied zwischen diesen beiden Methoden besteht darin, dass Continuous Cursor eine kontinuierliche Kontrolle der Cursor ermöglicht. Hier verwenden wir die absolute 2D-Position des Daumens auf dem Touchpad und platzieren den Cursor der jeweiligen Tastaturhälfte entsprechend. Durch Drücken des Touchpads wird die Texteingabe bestätigt. Ansonsten ist diese Methode analog zur Discrete-Cursor-Methode.

Experiment

Wir präsentierten die Methoden den Teilnehmern (N = 24) in unserer Studie, um ihre Leistung bei der Texteingabe und ihre Nutzerpräferenzen gegenüber unserem Design Space für die selektive Texteingabe in VR zu analysieren.

Die Ergebnisse machen deutlich, dass die Leistung (Geschwindigkeit und Fehlerrate), die kognitive Belastung und die User Experience unserer implementierten Pointing-Methoden (Head und Controller) im Vergleich zu verwandten Arbeiten in VR [ Gonzalez et al, 2009 ] oder Nicht-VR [ Markussen et al, 2013 ] überdurchschnittlich besser sind.

Allerdings waren die eher natürlichen Controller-Tapping- und Freehand-Methoden aufgrund ihrer höheren technischen und physikalischen Einschränkungen schlechter – aber besser als erwartet. Insbesondere in VR erwiesen sich User Experience und die kognitive Belastung als wesentliche Faktoren für die Performance der Texteingabe.

Zusammengefasst bilden der Design Space und die evaluierten Methoden eine solide Grundlage für den Vergleich zukünftiger auswahlbasierter Texteingabe-Methoden in VR.

Um aufstrebenden VR-Designern und Entwicklern bei der Texteingabe in VR zu helfen, Erfahrungen zu schaffen, die die Nutzer nicht frustrieren oder Übelkeit hervorrufen, haben wir das folgende Entscheidungshilfe-Tool auf der Grundlage von [ Gonzales et al, 2009 ] entwickelt (siehe Abbildung). Basierend auf unseren Erkenntnissen muss dieses Werkzeug zur Texteingabe aktualisiert werden.

Die Entscheidung, welches Eingabegerät zu wählen ist, schränkt die Auswahl der Techniken ein, wenn zusätzliche Geräte (beispielsweise Handschuhe, Kameras, Tastaturen, etc.) oder das Tracking der Controller erforderlich ist.

Dennoch empfehlen wir Controller mit mindestens einer Taste zum Bestätigen der Eingabe aufgrund ihrer Robustheit und Vertrautheit. Wenn jedoch der Nutzer „seine Hände frei braucht“ oder kein VR- oder sonstiger Game-Controller zur Verfügung steht, sollte man neben der Spracherkennung unbedingt auch das Head Pointing in Verbindung mit einer „dwelling time“ berücksichtigen. Sprache hat jedoch große Nachteile, wie Erkennungs-, Datenschutz– und Fehlerkorrektur-Probleme.

In bezug auf unsere Studienergebnisse, einschließlich Geschwindigkeit und Genauigkeit sowie Nutzerpräferenz, hat das Controller Pointing deutlich besser abgeschnitten als alle anderen getesteten Methoden.

Wenn jedoch kein getrackter Handheld-Controller verfügbar ist, wäre die nächste Methode das Head Pointing, es sei denn, dass geringe physische Belastung von besonderer Bedeutung ist. Nur dann ist die Continuous Cursor Control mittels d-Pad die richtige Wahl.

Referenzen

Marco Speicher, Anna Maria Feit, Pascal Ziegler and Antonio Krüger. 2018. Selection-based Text Entry in Virtual Reality . In: Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems (CHI ’18). ACM, New York, NY, USA, Paper 647, 13 pages

Doug Bowman, Ernst Kruijff, Joseph J. LaViola Jr. and Ivan P. Poupyrev. 2004. 3D User Interfaces: Theory and Practice, CourseSmart eTextbook . Addison-Wesley

Doug A. Bowman, Christopher J. Rhoton and Marcio S. Pinho. 2002. Text Input Techniques for Immersive Virtual Environments: An Empirical Comparison . In: Proceedings of the Human Factors and Ergonomics Society Annual Meeting 46, 26 (2002), 2154–2158

Peter J. Gianaros, Eric R. Muth, J. Toby Mordkoff, Max E. Levine, and Robert M. Stern. 2001. A questionnaire for the assessment of the multiple dimensions of motion sickness. In: Aviation, Spac, and Environmental Medicine 72, 2 (2001), 115

Gabriel Gonzalez, Jose P Molina, Arturo S Garcıa, Diego Martınez, and Pascual Gonzalez. 2009. Evaluation of text input techniques in immersive virtual environments . In: New Trends on Human–Computer Interaction. Springer, 109–118

S. G. Hart and L. E. Stavenland. 1988. Development of NASA-TLX (Task LoadIndex): Results of empirical and theoreticalresearch . In: Human Mental Workload, P. A. Hancock and N. Meshkati (Eds.). Elsevier, Chapter 7, 139–183

Jason Jerald. 2015. The VR book: human-centered design for virtual reality .

Bettina Laugwitz, Theo Held and Martin Schrepp. 2008. Construction andevaluation of a user experience questionnaire . In: Symposium of the Austrian HCI and Usability Engineering Group. Springer, 63–76

Kun Chang Lee and Namho Chung. 2008. Empirical analysis of consumerreaction to the virtual reality shopping mall . In: Computers in Human Behavior 24, 1 (2008), 88 – 104

Jia-Wei Lin, Ping-Hsuan Han, Jiun-Yu Lee, Yang-Sheng Chen, Ting-Wei Chang, Kuan-Wen Chen, and Yi-Ping Hung. 2017. Visualizing the Keyboard in Virtual Reality for Enhancing Immersive Experience . In: ACM Siggraph 2017 Posters (Siggraph ’17). ACM, New York, NY, USA, Article 35, 2 pages

Allan MacLean, Richard M. Young, Victoria M. E. Bellotti, and Thomas P. Moran. 1991. Questions, Options and Criteria: Elements of Design Space Analysis . In: Human-Computer Interaction 6, 3 (Sept. 1991), 201–250

Anders Markussen, Mikkel R Jakobsen, and Kasper Hornbæk. 2013. Selection-based mid-air text entry on large displays . In: IFIP Conference on Human-Computer Interaction. Springer, 401–418

Mark McGill, Daniel Boland, Roderick Murray-Smith, and Stephen Brewster. 2015. A Dose of Reality: Overcoming Usability Challenges in VR Head-Mounted Displays . In: Proceedings of the 33rd Annual ACM Conference on Human Factors in Computing Systems (CHI ’15). ACM, New York, NY, USA, 2143–2152

James Walker, Bochao Li, Keith Vertanen, and Scott Kuhl. 2017. Efficient Typing on a Visually Occluded Physical Keyboard. In: Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems (CHI ’17). ACM, New York, NY, USA, 5457–5461

Chun Yu, Yizheng Gu, Zhican Yang, Xin Yi, Hengliang Luo, and Yuanchun Shi. 2017. Tap, Dwell or Gesture?: Exploring Head-Based Text Entry Techniques for HMDs . In: Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems (CHI ’17). ACM, New York, NY, USA, 4479–4488

Quelle:

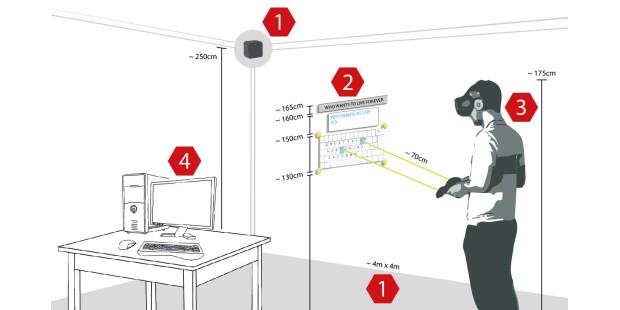

Foto: Diese Abbildung veranschaulicht den Versuchsaufbau unserer Studie (1) HTC Vive optischer

Autor: Marco Speicher

Marco Speicher ist seit 2014 wissenschaftlicher Mitarbeiter und Doktorand am Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI). 2014 absolvierte er den Master of Science (M.Sc.) an der Universität des Saarlandes zum Thema „Exploring 3D Interaction Techniques for Stereoscopic Content using Consumer Tracking Devices“.

https://www.pcwelt.de/a/selektive-texteingabe-in-der-virtuellen-realitaet,3452524